Combien de caméras industrielles un hôte peut-il supporter dans un système de vision ?

Dans les systèmes de vision modernes, déterminer combien de caméras un seul hôte (par exemple, un ordinateur ou un serveur) peut supporter est une question cruciale pour la conception du système, sa scalabilité et son optimisation des coûts. La réponse dépend de plusieurs facteurs interconnectés, y compris les capacités matérielles, l'efficacité logicielle, les spécifications des caméras industrielles et les exigences de l'application. Cet article explore ces variables clés et fournit un cadre pour estimer la capacité des caméras dans un système de vision.

1. Composants matériels et leur impact

Le matériel de l'hôte est la base du support des caméras, avec deux aspects clés jouant un rôle majeur.

1.1 Unités de traitement : CPU et GPU

Le CPU gère une large gamme de tâches de traitement d'images, allant du filtrage de base à l'inférence d'apprentissage machine complexe. Les caméras haute résolution ou à haut débit générant de grands volumes de données, cela met sous pression le CPU. Les CPUs multi-cœurs, comme l'Intel i9 ou AMD Threadripper, peuvent répartir les tâches entre les cœurs pour un traitement parallèle. D'un autre côté, les GPU révolutionnent les systèmes de vision en accélérant le calcul parallèle, ce qui est particulièrement crucial pour des tâches comme la vision 3D et l'apprentissage profond dans la conduite autonome. Les caméras intégrées avec des pipelines optimisés pour GPU, comme CUDA dans les GPU NVIDIA, déchargent le traitement du CPU, potentiellement triplant le nombre de caméras prises en charge.

1.2 Mémoire, Stockage et E/S

Une RAM suffisante est essentielle pour tamponner les flux vidéo et les données traitées. Une caméra 4K à 30 IPS génère environ 300 Mo/s de données non compressées, augmentant les besoins en mémoire dans les configurations multicaméras. Pour les caméras haute résolution, allouez au moins 4 à 8 Go de RAM par caméra. Un stockage haute vitesse, comme les SSD NVMe, et des interfaces I/O robustes telles que USB 3.2 et PCIe sont vitaux pour l'ingestion et le stockage des données. Les interfaces héritées peuvent sérieusement limiter la scalabilité du système.

2. Industriel Spécifications de la caméra

Les paramètres des caméras industrielles influencent directement la charge sur le système hôte, principalement grâce aux deux facteurs critiques suivants.

2.1 Résolution et taux d'images

Une résolution et un taux d'images plus élevés signifient plus de données à traiter. Une caméra 4K produit quatre fois plus de pixels qu'une caméra 1080p, augmentant considérablement les exigences en matière de traitement. De même, une caméra à 120 IPS génère quatre fois plus de données qu'une caméra à 30 IPS. En retransmission sportive, des caméras à haute résolution et à haut taux d'images sont utilisées mais mettent une charge extrêmement élevée sur l'hôte, nécessitant du matériel puissant pour éviter la perte de qualité.

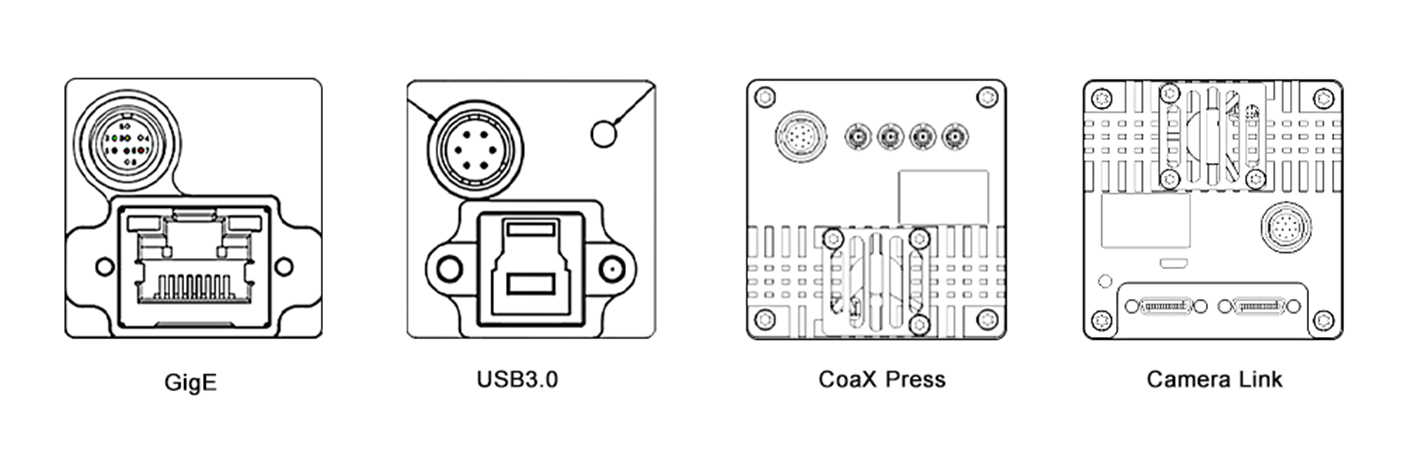

2.2 Compression et Interface

Le choix du format de compression influence la taille des données et le coût de traitement. Les formats compressés comme H.264 réduisent la bande passante mais nécessitent une décompression sur l'hôte. Les formats non compressés offrent une fidélité supérieure mais consomment plus de ressources. De plus, le type d'interface de la caméra est crucial. Les interfaces haute vitesse comme GigE Vision et CoaXPress permettent un transfert de données efficace pour les configurations multi-caméras, tandis que les interfaces héritées comme USB 2.0 limitent la scalabilité en raison d'une bande passante limitée.

3. Logiciel et Pipeline de Traitement

L'efficacité du logiciel est également cruciale, ces deux domaines étant clés pour la performance du système.

3.1 Système d'Exploitation et Outils Logiciels

Le système d'exploitation et ses pilotes forment la base logicielle. Les systèmes d'exploitation temps réel (RTOS) minimisent la latence, idéaux pour des applications comme le contrôle robotique. Les systèmes basés sur Linux sont populaires grâce au soutien open-source. Des pilotes optimisés améliorent les performances matérielles. Les logiciels de vision et les bibliothèques, tels qu'OpenCV, MATLAB et les cadres de deep learning comme TensorFlow et PyTorch, varient en efficacité computationnelle. Par exemple, un hôte exécutant un modèle YOLO accéléré par GPU peut supporter moins de caméras qu'un autre utilisant une détection de contour de base en raison d'une complexité supérieure.

3.2 Multithreading et Optimisation

Une multithreading et une parallélisation efficaces sont essentielles pour maximiser les performances du système. La multithreading permet aux tâches de s'exécuter simultanément sur les cœurs CPU, tandis que la parallélisation utilise les GPU pour le traitement des données. Les technologies comme OpenMP et CUDA fournissent des cadres pour l'implémentation. Dans un système de surveillance multicaméra, OpenMP peut répartir le traitement des flux vidéo entre les cœurs CPU, et CUDA peut accélérer l'analyse d'images sur le GPU, permettant ainsi de gérer plus de caméras.

4. Exigences de l'application

La complexité de la tâche de vision détermine l'allocation des ressources, avec le temps réel et la complexité du traitement comme principaux déterminants.

4.1 Traitement en temps réel versus hors connexion

Les applications en temps réel, telles que la conduite autonome et l'automatisation industrielle, nécessitent un traitement immédiat avec une faible latence, limitant le nombre de caméras qu'un hôte peut prendre en charge. Le traitement hors connexion, comme l'analyse vidéo par lots, peut gérer plus de caméras mais produit des résultats retardés.

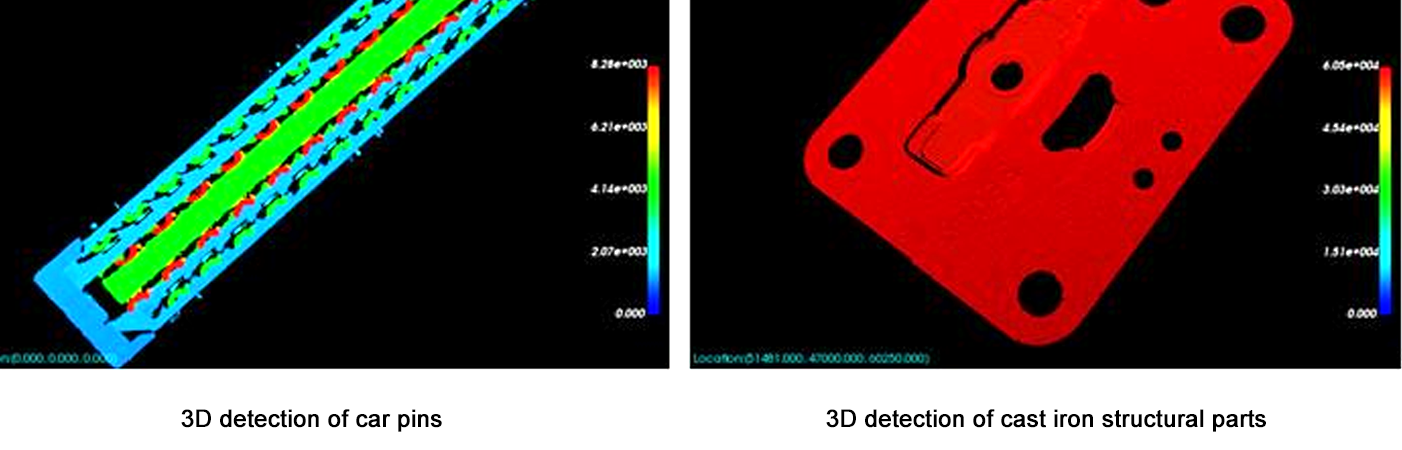

4.2 Complexité du traitement

Les tâches simples comme la détection de mouvement imposent une faible charge de calcul, permettant à un hôte de prendre en charge plus de caméras. Les tâches complexes comme la reconstruction 3D ou la reconnaissance faciale avancée nécessitent des ressources importantes, réduisant le nombre de caméras prises en charge. Par exemple, un hôte peut supporter 10 caméras pour la détection de mouvement mais seulement 3 pour l'estimation en temps réel de la profondeur 3D.

5. Cadre d'Estimation

Utilisez les étapes suivantes pour estimer la capacité des caméras :

Définir les Paramètres des Caméras : Résolution, taux d'images, compression et interface.

Calculer le Débit de Données : Débit de Données Non Compressées = Résolution × Taux d'Images × Profondeur de Bits / 8 (par exemple, 1080p à 30 FPS = 1920×1080×30×24 / 8 = ~1,4 Go/s).

Évaluer les Limites du Matériel : S'assurer que la puissance de traitement CPU/GPU ≥ débit total des données × facteur de surcoût de traitement (2–5× pour les tâches complexes).

Test avec prototypes : Utilisez des outils de benchmark (par exemple, Intel VTune, NVIDIA Nsight) pour mesurer l'utilisation des ressources pour une seule caméra, puis échellez linéairement (avec des ajustements pour les gains/pertes de parallélisation).

Conclusion

Le nombre de caméras qu'un hôte peut supporter dans un système de vision n'est pas un nombre fixe, mais un équilibre entre les capacités matérielles, les spécifications des caméras, l'optimisation logicielle et la complexité des tâches. Pour la plupart des systèmes, commencer par un prototype et augmenter progressivement tout en surveillant l'utilisation des ressources est l'approche la plus fiable. Comme le matériel (par exemple, des GPU plus rapides, des accélérateurs AI) et le logiciel (par exemple, des frameworks de calcul en périphérie) continuent d'évoluer rapidement, la capacité à supporter plus de caméras avec des performances supérieures continuera d'augmenter. Cette évolution permettra le développement de solutions de vision plus sophistiquées et évolutives, ouvrant de nouvelles possibilités dans divers secteurs, de la santé et des transports à la sécurité et au divertissement.

Cet article fournit une compréhension de base pour les architectes de systèmes et les ingénieurs, en soulignant la nécessité de tests et d'optimisation spécifiques pour répondre aux exigences particulières des applications. En prenant soigneusement en compte tous les facteurs en jeu, il est possible de concevoir des systèmes de vision à la fois efficaces et capables de faire face aux exigences croissantes des applications modernes.