Quante Camere Industriali Può Supportare Un Host In Un Sistema Di Visione?

Nelle moderne sistemi di visione, determinare quante telecamere un singolo host (ad esempio, un computer o un server) può supportare è una domanda critica per la progettazione del sistema, la scalabilità e l'ottimizzazione dei costi. La risposta dipende da numerosi fattori interconnessi, tra cui le capacità hardware, l'efficienza software, le specifiche delle telecamere industriali e i requisiti dell'applicazione. Questo articolo esplora queste variabili chiave e fornisce un quadro per stimare la capacità delle telecamere in un sistema di visione.

1. Componenti Hardware e il loro Impatto

L'hardware dell'host è la base del supporto alle telecamere, con due aspetti chiave che giocano un ruolo principale.

1.1 Unità di Elaborazione: CPU e GPU

La CPU gestisce un ampio spettro di compiti di elaborazione delle immagini, dalla filtratura di base a inferenze complesse di apprendimento automatico. Le telecamere ad alta risoluzione o con frame rate elevati generano volumi di dati consistenti, mettendo sotto pressione la CPU. Le CPU multi-core, come l'Intel i9 o AMD Threadripper, possono distribuire i compiti tra i core per un'elaborazione parallela. D'altra parte, le GPU rivoluzionano i sistemi visivi accelerando il calcolo parallelo, specialmente fondamentale per compiti come la visione 3D e l'apprendimento profondo nella guida autonoma. Le telecamere integrate con pipeline ottimizzate per GPU, come CUDA nelle GPU NVIDIA, scaricano l'elaborazione dalla CPU, potenzialmente triplicando il numero di telecamere supportate.

1.2 Memoria, Archiviazione e I/O

Una quantità sufficiente di RAM è essenziale per bufferizzare flussi video e dati elaborati. Una telecamera 4K a 30 FPS genera circa 300 MB/s di dati non compressi, aumentando i requisiti di memoria in configurazioni con più telecamere. Per telecamere ad alta risoluzione, assegnare almeno 4-8 GB di RAM per telecamera. Un archiviazione ad alta velocità, come NVMe SSD, e interfacce I/O robuste come USB 3.2 e PCIe sono fondamentali per l'ingresso e la memorizzazione dei dati. Le interfacce obsolete potrebbero limitare gravemente la scalabilità del sistema.

2. Industriale Specifiche della telecamera

I parametri delle telecamere industriali influiscono direttamente sul carico del sistema host, principalmente attraverso i seguenti due fattori critici.

2.1 Risoluzione e frame rate

Una risoluzione e un frame rate più alti significano più dati da elaborare. Una telecamera 4K produce quattro volte più pixel di una telecamera 1080p, aumentando notevolmente i requisiti di elaborazione. Analogamente, una telecamera a 120 FPS genera quattro volte più dati di una a 30 FPS. Nella trasmissione sportiva vengono utilizzate telecamere ad alta risoluzione e ad alto frame rate, ma queste pongono un carico estremamente elevato sul sistema, richiedendo hardware potente per evitare la perdita di qualità.

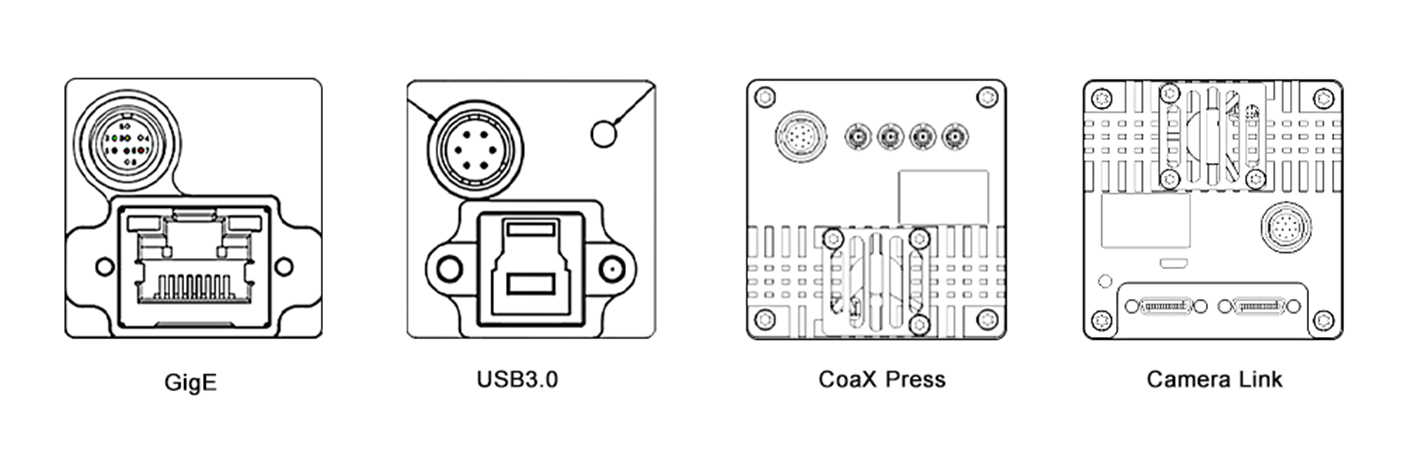

2.2 Compressione e Interfaccia

La scelta del formato di compressione influenza la dimensione dei dati e il carico di elaborazione. I formati compressi come H.264 riducono la larghezza di banda ma richiedono decodifica sul sistema host. I formati non compressi offrono una fedeltà maggiore ma consumano più risorse. Inoltre, il tipo di interfaccia della telecamera è fondamentale. Le interfacce ad alta velocità come GigE Vision e CoaXPress consentono un trasferimento efficiente dei dati in configurazioni con più telecamere, mentre le interfacce legacy come USB 2.0 limitano la scalabilità a causa della larghezza di banda limitata.

3. Software e Pipeline di Elaborazione

L'efficienza del software è altrettanto critica, con queste due aree che sono fondamentali per le prestazioni del sistema.

3.1 Sistema Operativo e Strumenti Software

Il sistema operativo e i suoi driver costituiscono la base del software. I sistemi operativi in tempo reale (RTOS) minimizzano la latenza, ideali per applicazioni come il controllo robotico. I sistemi basati su Linux sono popolari grazie al supporto open-source. I driver ottimizzati migliorano le prestazioni hardware. Il software di visione e le librerie, come OpenCV, MATLAB e framework di deep learning come TensorFlow e PyTorch, variano in termini di efficienza computazionale. Ad esempio, un host che esegue un modello YOLO accelerato da GPU potrebbe supportare meno camere di uno che utilizza una semplice rilevazione dei bordi a causa di una maggiore complessità.

3.2 Multithreading e Ottimizzazione

Un'efficiente multithreading e parallelizzazione sono fondamentali per massimizzare le prestazioni del sistema. La multithreading consente l'esecuzione concorrente dei compiti sui core CPU, mentre la parallelizzazione sfrutta le GPU per il processing dei dati. Tecnologie come OpenMP e CUDA forniscono framework per l'implementazione. In un sistema di sorveglianza con più telecamere, OpenMP può distribuire il processing del flusso delle telecamere sui core CPU, e CUDA può accelerare l'analisi delle immagini sulla GPU, consentendo di gestire più telecamere.

4. Requisiti dell'Applicazione

La complessità del compito di visione determina l'allocazione delle risorse, con il tempo reale e la complessità di elaborazione che sono i principali determinanti.

4.1 Elaborazione in Tempo Reale vs. Elaborazione Offline

Le applicazioni in tempo reale, come la guida autonoma e l'automazione industriale, richiedono un'elaborazione immediata con bassa latenza, limitando il numero di telecamere che un host può supportare. L'elaborazione offline, come l'analisi batch di video, può gestire più telecamere ma ha risultati ritardati.

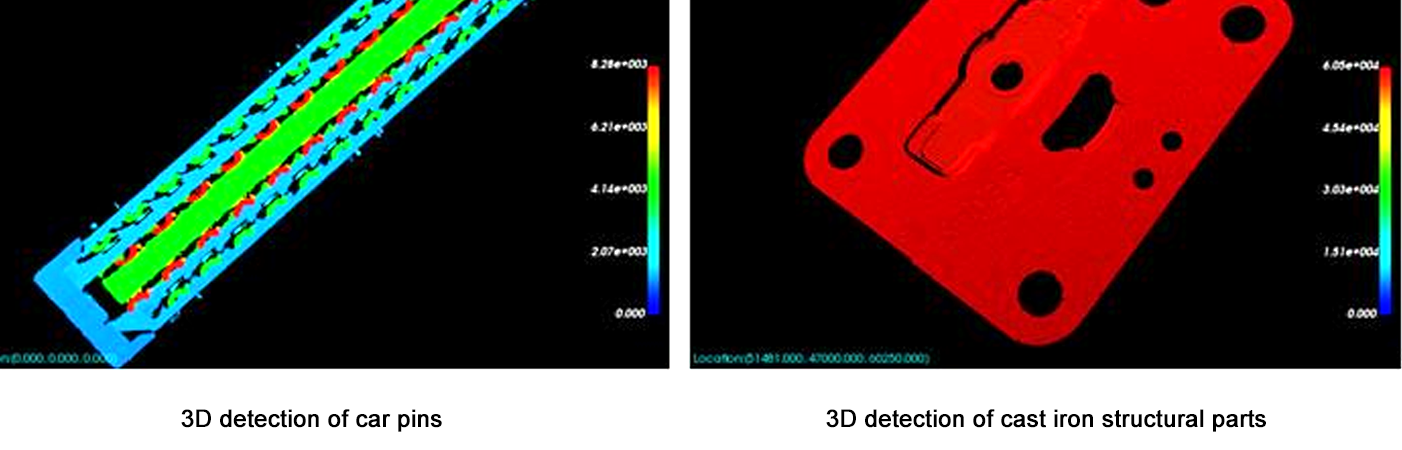

4.2 Complessità di Elaborazione

Compiti semplici come la rilevazione del movimento impongono un basso carico computazionale, consentendo a un host di supportare più camere. Compiti complessi come la ricostruzione 3D o il riconoscimento facciale avanzato richiedono risorse significative, riducendo il numero di camere supportate. Ad esempio, un host potrebbe supportare 10 camere per la rilevazione del movimento ma solo 3 per la stima in tempo reale della profondità 3D.

5. Framework di Stima

Usa i seguenti passaggi per stimare la capacità delle camere:

Definisci Parametri delle Camere: Risoluzione, frame rate, compressione e interfaccia.

Calcola il Throughput dei Dati: Data Rate Non Compresso = Risoluzione × Frame Rate × Bit Depth / 8 (ad esempio, 1080p a 30 FPS = 1920×1080×30×24 / 8 = ~1,4 GB/s).

Valuta i Limiti Hardware: Assicurati che la potenza di elaborazione CPU/GPU sia ≥ throughput totale dei dati × fattore di overhead di elaborazione (2–5× per compiti complessi).

Test con Prototipi: Usa strumenti di benchmark (ad esempio, Intel VTune, NVIDIA Nsight) per misurare l'utilizzo delle risorse per una singola telecamera, quindi scala linearmente (con aggiustamenti per i guadagni/perdite di parallelizzazione).

Conclusione

Il numero di telecamere che un host può supportare in un sistema di visione non è un numero fisso, ma un equilibrio tra le capacità hardware, le specifiche delle telecamere, l'ottimizzazione del software e la complessità dei compiti. Per la maggior parte dei sistemi, partire con un prototipo e scalare gradualmente mentre si monitora l'utilizzo delle risorse è l'approccio più affidabile. Man mano che hardware (ad esempio, GPU più veloci, acceleratori AI) e software (ad esempio, framework di calcolo sul bordo) continuano a evolversi rapidamente, la capacità di supportare più telecamere con prestazioni superiori continuerà ad aumentare. Questa evoluzione consentirà lo sviluppo di soluzioni di visione più sofisticate e scalabili, aprendo nuove possibilità in vari settori, dall'assistenza sanitaria e i trasporti alla sicurezza e all'intrattenimento.

Questo articolo fornisce una comprensione di base per gli architetti di sistema e gli ingegneri, sottolineando la necessità di test personalizzati e ottimizzazione per soddisfare le esigenze specifiche delle applicazioni. Considerando attentamente tutti i fattori coinvolti, è possibile progettare sistemi visivi che siano efficienti e in grado di gestire i continui aumenti delle richieste delle applicazioni moderne.