Quantas Câmeras Industriais Um Host Pode Suportar em um Sistema de Visão?

Em sistemas de visão modernos, determinar quantas câmeras um único host (por exemplo, um computador ou servidor) pode suportar é uma questão crítica para o design do sistema, escalabilidade e otimização de custos. A resposta depende de vários fatores interrelacionados, incluindo capacidades de hardware, eficiência de software, especificações de câmeras industriais e requisitos de aplicação. Este artigo explora essas variáveis-chave e fornece um quadro para estimar a capacidade de câmeras em um sistema de visão.

1. Componentes de Hardware e Seu Impacto

O hardware do host é a base do suporte às câmeras, com dois aspectos principais desempenhando um papel significativo.

1.1 Unidades de Processamento: CPU e GPU

A CPU lida com uma ampla gama de tarefas de processamento de imagens, desde filtros básicos até inferências complexas de aprendizado de máquina. Câmeras de alta resolução ou alta taxa de quadros geram grandes volumes de dados, sobrecarregando a CPU. CPUs multi-core, como o Intel i9 ou AMD Threadripper, podem distribuir tarefas entre os núcleos para processamento paralelo. Por outro lado, GPUs revolucionam sistemas de visão ao acelerar o computação paralela, especialmente crucial para tarefas como visão 3D e aprendizado profundo em direção autônoma. Câmeras integradas com pipelines otimizados para GPU, como CUDA em GPUs NVIDIA, retiram o processamento da CPU, potencialmente triplicando o número de câmeras suportadas.

1.2 Memória, Armazenamento e E/S

RAM suficiente é essencial para bufferizar transmissões de vídeo e dados processados. Uma câmera 4K a 30 FPS gera cerca de 300 MB/s de dados não comprimidos, aumentando os requisitos de memória em configurações com várias câmeras. Para câmeras de alta resolução, aloque pelo menos 4–8 GB de RAM por câmera. Armazenamento de alta velocidade, como SSDs NVMe, e interfaces robustas de I/O, como USB 3.2 e PCIe, são fundamentais para ingestão e armazenamento de dados. Interfaces legadas podem limitar severamente a escalabilidade do sistema.

2. Industrial Especificações da Câmera

Os parâmetros da câmera industrial influenciam diretamente a carga no sistema host, principalmente através dos seguintes dois fatores críticos.

2.1 Resolução e Taxa de Quadros

Uma resolução e taxa de quadros mais altas significam mais dados para processar. Uma câmera 4K produz quatro vezes mais pixels do que uma câmera 1080p, aumentando significativamente as demandas de processamento. Da mesma forma, uma câmera de 120 FPS gera quatro vezes mais dados do que uma de 30 FPS. Em transmissões esportivas, câmeras de alta resolução e alta taxa de quadros são usadas, mas impõem uma carga extremamente alta ao sistema hospedeiro, exigindo hardware poderoso para evitar perda de qualidade.

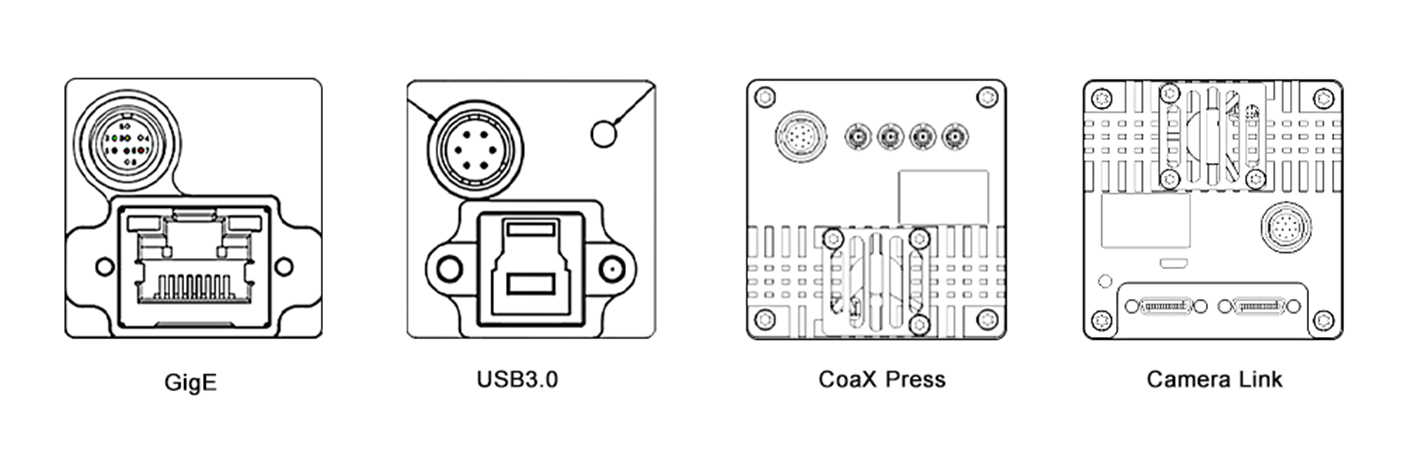

2.2 Compressão e Interface

A escolha do formato de compressão afeta o tamanho dos dados e a sobrecarga de processamento. Formatos comprimidos como H.264 reduzem a largura de banda, mas exigem decodificação no sistema hospedeiro. Formatos não comprimidos oferecem maior fidelidade, mas consomem mais recursos. Além disso, o tipo de interface da câmera é crucial. Interfaces de alta velocidade, como GigE Vision e CoaXPress, permitem transferência eficiente de dados em configurações com múltiplas câmeras, enquanto interfaces legadas, como USB 2.0, restringem a escalabilidade devido à largura de banda limitada.

3. Software e Pipeline de Processamento

A eficiência do software é igualmente crítica, com essas duas áreas sendo fundamentais para o desempenho do sistema.

3.1 Sistema Operacional e Ferramentas de Software

O sistema operacional e seus drivers formam a base de software. Sistemas operacionais em tempo real (RTOS) minimizam a latência, ideais para aplicações como controle robótico. Sistemas baseados em Linux são populares devido ao suporte open-source. Drivers otimizados melhoram o desempenho do hardware. Softwares e bibliotecas de visão, como OpenCV, MATLAB e frameworks de aprendizado profundo como TensorFlow e PyTorch, variam em eficiência computacional. Por exemplo, um host executando um modelo YOLO acelerado por GPU pode suportar menos câmeras do que aquele usando detecção básica de borda devido à maior complexidade.

3.2 Multithreading e Otimização

A multithreading e a paralelização eficientes são fundamentais para maximizar o desempenho do sistema. A multithreading permite que tarefas sejam executadas simultaneamente nos núcleos da CPU, enquanto a paralelização aproveita as GPUs para processamento de dados. Tecnologias como OpenMP e CUDA fornecem estruturas para implementação. Em um sistema de vigilância com múltiplas câmeras, o OpenMP pode distribuir o processamento dos feeds das câmeras pelos núcleos da CPU, e o CUDA pode acelerar a análise de imagens na GPU, permitindo lidar com mais câmeras.

4. Requisitos de Aplicação

A complexidade da tarefa de visão determina a alocação de recursos, com o tempo real e a complexidade de processamento sendo os principais fatores determinantes.

4.1 Processamento em Tempo Real vs. Offline

Aplicações em tempo real, como direção autônoma e automação industrial, exigem processamento imediato com baixa latência, limitando o número de câmeras que um host pode suportar. O processamento offline, como análise de vídeos em lote, pode lidar com mais câmeras, mas tem resultados atrasados.

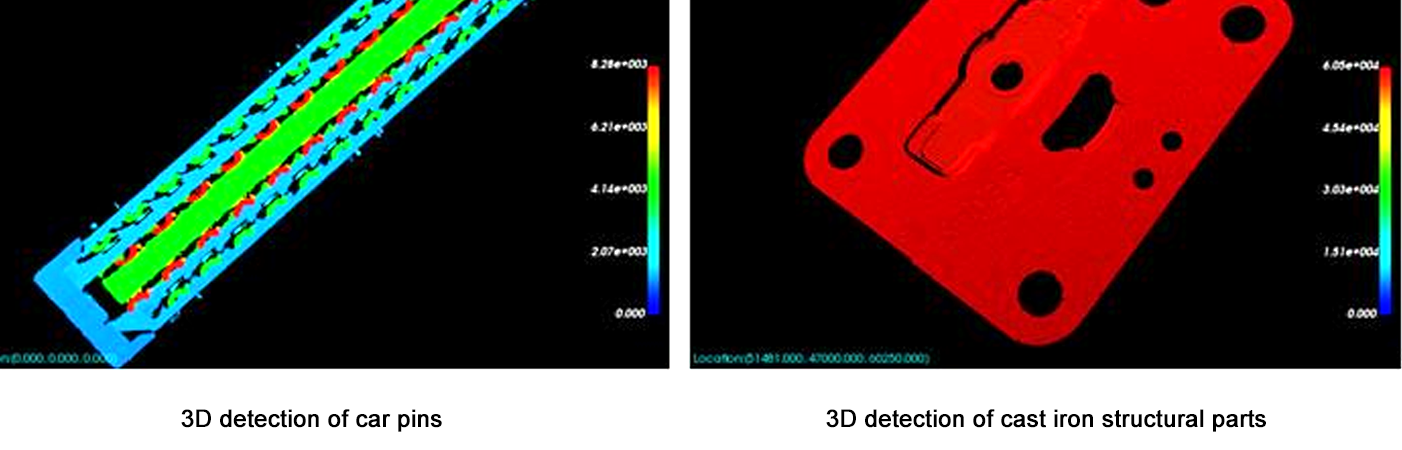

4.2 Complexidade de Processamento

Tarefas simples, como detecção de movimento, impõem uma carga computacional baixa, permitindo que um host suporte mais câmeras. Tarefas complexas, como reconstrução 3D ou reconhecimento facial avançado, exigem recursos significativos, reduzindo o número de câmeras suportadas. Por exemplo, um host pode suportar 10 câmeras para detecção de movimento, mas apenas 3 para estimação de profundidade 3D em tempo real.

5. Framework de Estimativa

Use os seguintes passos para estimar a capacidade da câmera:

Defina Parâmetros da Câmera: Resolução, taxa de quadros, compressão e interface.

Calcule a Taxa de Transferência de Dados: Taxa de Dados Não Comprimida = Resolução × Taxa de Quadros × Profundidade de Bits / 8 (ex., 1080p a 30 FPS = 1920×1080×30×24 / 8 = ~1,4 GB/s).

Avalie Limites de Hardware: Certifique-se de que o poder de processamento da CPU/GPU ≥ taxa total de throughput de dados × fator de sobrecarga de processamento (2–5× para tarefas complexas).

Teste com Protótipos: Use ferramentas de benchmark (por exemplo, Intel VTune, NVIDIA Nsight) para medir o uso de recursos para uma única câmera, depois dimensione linearmente (com ajustes para ganhos/perdas de paralelização).

Conclusão

O número de câmeras que um host pode suportar em um sistema de visão não é um número fixo, mas um equilíbrio entre as capacidades de hardware, especificações das câmeras, otimização de software e complexidade da tarefa. Para a maioria dos sistemas, começar com um protótipo e gradualmente escalar enquanto monitora o uso de recursos é a abordagem mais confiável. À medida que o hardware (por exemplo, GPUs mais rápidas, aceleradores de IA) e o software (por exemplo, frameworks de computação na borda) continuam a evoluir rapidamente, a capacidade de suportar mais câmeras com melhor desempenho continuará a crescer. Essa evolução permitirá o desenvolvimento de soluções de visão mais sofisticadas e escaláveis, abrindo novas possibilidades em vários setores, desde saúde e transporte até segurança e entretenimento.

Este artigo fornece uma compreensão fundamental para arquitetos de sistemas e engenheiros, enfatizando a necessidade de testes e otimização personalizados para atender às demandas específicas de cada aplicação. Ao considerar cuidadosamente todos os fatores envolvidos, é possível projetar sistemas de visão que sejam tanto eficientes quanto capazes de lidar com as crescentes demandas das aplicações modernas.