Hur många industriella kameror kan en värdbaser stödja i ett visionsystem?

I moderna visionsystem är det att avgöra hur många kameror en enskild värdator (t.ex. en dator eller server) kan stödja en kritisk fråga för systemdesign, skalbarhet och kostnadsoptimering. Svaret beror på flera sammanlänkade faktorer, inklusive hårdvaruförmågor, programvarueffektivitet, specifikationer för industriella kameror och tillämpningskrav. Denna artikel utforskar dessa nyckelvariabler och ger en ram för att uppskatta kamerakapaciteten i ett visionsystem.

1. Hårdvarukomponenter och deras påverkan

Värdatorns hårdvara är grunden för kamerastöd, med två huvudsakliga aspekter som spelar en stor roll.

1.1 Bearbetningsenhet: CPU och GPU

CPU:n hanterar en bred spektrum av bildbearbetningsuppgifter, från grundläggande filtrering till komplex maskininlärningss inference. Högupplösta eller högbeeldsfrekvenskameror genererar stora datavolymner, vilket belastar CPU:n. Flerkärniga CPU:er, som Intel i9 eller AMD Threadripper, kan distribuera uppgifter över kärnor för parallell bearbetning. Å andra sidan revolutionerar GPU:er synsystem genom att påskynda parallellberäkning, särskilt viktigt för uppgifter som 3D-vision och djupinlärning inom självkörande fordon. Kameror integrerade med GPU-optimerade pipelines, såsom CUDA i NVIDIA-GPU:er, tar bort bearbetning från CPU:n, vilket potentiellt kan fördubbla eller till och med tripler antalet stödda kameror.

1.2 Minne, lagring och I/O

Tillräckligt med RAM är avgörande för att puffra videostreams och bearbetad data. En 4K-kamera på 30 FPS genererar ungefär 300 MB/s av okomprimerad data, vilket höjer minneskraven i flerkamerasystem. För högupplösta kameror bör man tilldela minst 4–8 GB RAM per kamera. Hög hastighet lagring, som NVMe SSD:n, och robusta I/O-gränssnitt som USB 3.2 och PCIe är viktiga för datatransport och lagring. Äldre gränssnitt kan allvarligt begränsa systemets skalbarhet.

2. Industriell Kamera Specificeringsdata

Industrikameraparametrar påverkar direkt belastningen på värdsystemet, främst genom följande två kritiska faktorer.

2.1 Upplösning och Bildfrekvens

Högre upplösning och bildfrekvens betyder mer data att bearbeta. En 4K-kamera producerar fyra gånger fler pixlar än en 1080p-kamera, vilket ökar bearbetningskraven avsevärt. På samma sätt genererar en kamera på 120 FPS fyra gånger mer data än en på 30 FPS. Inom idrottssändningar används högupplösta, högbildfrekventa kameror, men dessa sätter en extremt hög belastning på värdatorn, vilket kräver kraftfulla hårdvaror för att undvika kvalitetsförluster.

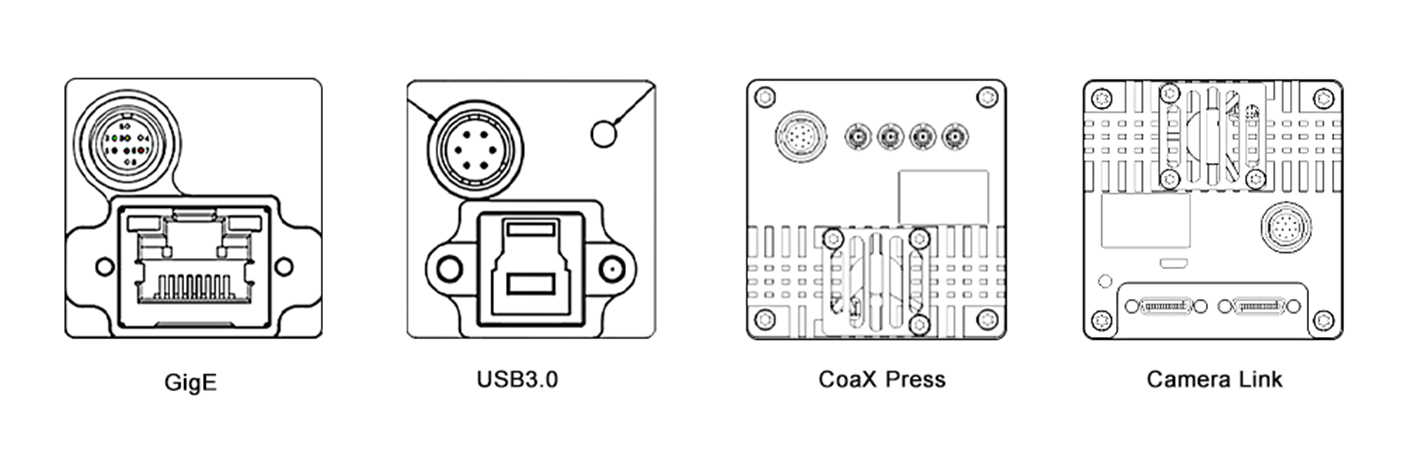

2.2 Komprimering och gränssnitt

Valet av komprimeringsformat påverkar datavolymen och bearbetningsöverhäng. Komprimerade format som H.264 minskar bandbredden men kräver avkodning på värdatorn. Okomprimerade format erbjuder högre trohet men förbrukar fler resurser. Dessutom är typen av kameragränssnitt avgörande. Hög hastighetsgränssnitt som GigE Vision och CoaXPress möjliggör effektiv dataöverföring för flerkamerainställningar, medan äldre gränssnitt som USB 2.0 begränsar skalbarheten på grund av begränsad bandbredd.

3. Programvara och bearbetningspipeline

Programvarueffektivitet är lika kritisk, med dessa två områden som är nyckel till systemets prestanda.

3.1 Operativsystem och Programvaruverktyg

Operativsystemet och dess drivrutiner utgör programvarans grund. Tidsberoende operativsystem (RTOS) minskar fördröjning, ideal för tillämpningar som robotstyrning. Linuxbaserade system är populära på grund av open-source-stöd. Optimerade drivrutiner förbättrar hårdvaruprestanda. Visionssprogramvara och bibliotek, såsom OpenCV, MATLAB och djupinlärningsramverk som TensorFlow och PyTorch, varierar i beräkningsmässig effektivitet. Till exempel kan en värd som körs med en GPU-akcelererad YOLO-modell stödja färre kameror än en som använder grundläggande kantradetection på grund av högre komplexitet.

3.2 Multitråding och Optimering

Effektiv multitrådning och parallellisering är avgörande för att maximera systemprestanda. Multitrådning låter uppgifter köras samtidigt på CPU-kärnor, medan parallellisering utnyttjar GPUn för dataprocestering. Tekniker som OpenMP och CUDA ger ramverk för implementering. I ett flerkameraövervakningssystem kan OpenMP distribuera bearbetning av kameraströmmar över CPU-kärnor, och CUDA kan accelerera bildanalys på GPU:n, vilket möjliggör hantering av fler kameror.

4. Programkrav

Komplexiteten i visionsuppgiften bestämmer resursfördelningen, där realtid och bearbetningskomplexitet är de huvudsakliga faktorerna.

4.1 Real-tid vs. Offline-bearbetning

Real-tidsapplikationer, såsom självkörande fordon och industriell automatisering, kräver omedelbar bearbetning med låg latens, vilket begränsar antalet kameror en värd kan stödja. Offline-bearbetning, som batchvideobearbetning, kan hantera fler kameror men har försenade resultat.

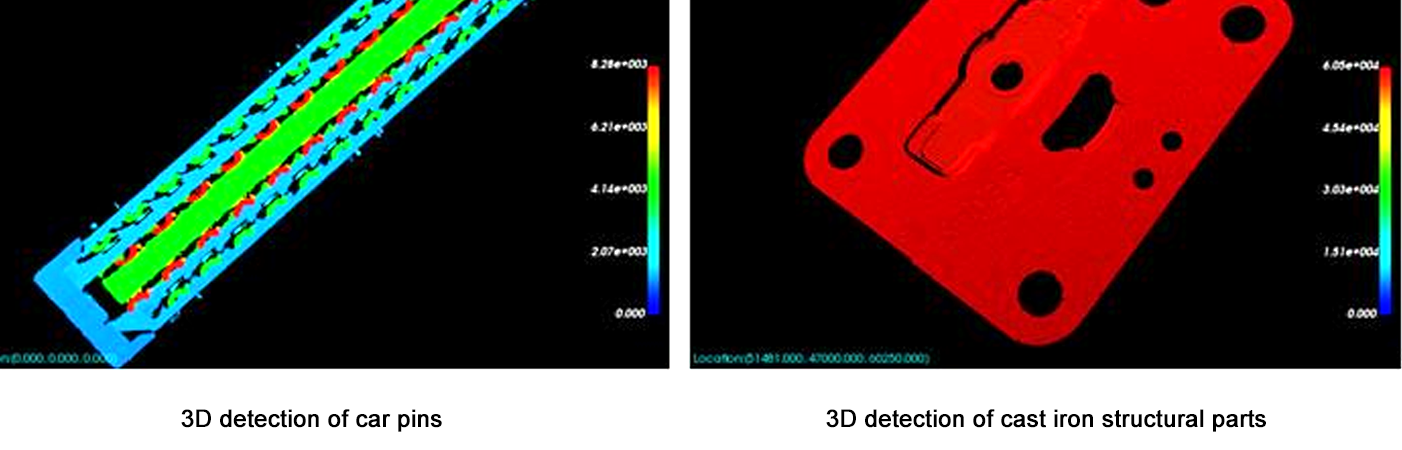

4.2 Bearbetningskomplexitet

Enkla uppgifter som rörelsedetektering pålägger låg beräkningsmässig belastning, vilket gör att en värd kan stödja fler kameror. Komplexa uppgifter som 3D-rekonstruktion eller avancerad ansiktsigenkänning kräver betydande resurser, vilket minskar antalet stödda kameror. Till exempel kan en värd stödja 10 kameror för rörelsedetektering men bara 3 för realtids 3D-djupuppskattning.

5. Uppskattningsramverk

Använd följande steg för att uppskatta kamerakapaciteten:

Definiera kameraparametrar: Upplösning, bildfrekvens, komprimering och gränssnitt.

Beräkna datatrafik: Okomprimerad datatakt = Upplösning × Bildfrekvens × Bitdjup / 8 (t.ex., 1080p vid 30 FPS = 1920×1080×30×24 / 8 = ~1,4 GB/s).

Bedöm hårdvarugränsen: Se till att CPU/GPU-bearbetningskraft ≥ total datatrafik × bearbetningsöverhängsfaktor (2–5× för komplexa uppgifter).

Test med prototyper: Använd benchmark-verktyg (t.ex., Intel VTune, NVIDIA Nsight) för att mäta resursanvändning för en enskild kamera, sedan skala linjärt (med justeringar för vinster/fördelar av parallelisering).

Slutsats

Antalet kameror som en värddator kan stödja i ett visionsystem är inte ett fast tal utan en balans mellan hårdvaruförmågor, kameraspecifikationer, programvaruoptimering och uppgiftskomplexitet. För de flesta system är det mest pålitliga sättet att börja med en prototyp och allt eftersom skala upp medan man övervakar resursanvändningen. Medan hårdvara (t.ex., snabbare GPU:er, AI-acceleratorer) och programvara (t.ex., edge computing-ramverk) fortsätter att utvecklas snabbt, kommer kapaciteten att stödja fler kameror med högre prestanda att fortsätta växa. Denna utveckling kommer att möjliggöra utvecklingen av mer sofistikerade och skalbara visionslösningar, vilket öppnar nya möjligheter inom olika branscher, från hälso- och sjukvård och transport till säkerhet och underhållning.

Denna artikel ger en grundläggande förståelse för systemarkitekter och ingenjörer, med tonvikt på behovet av anpassad testning och optimering för att uppfylla specifika tillämpningskrav. Genom att noga överväga alla faktorer som är involverade är det möjligt att designa visionsystem som är både effektiva och kapabla att hantera de allt ökande kraven från moderna tillämpningar.