Wie viele Industrie-Kameras kann ein Host in einem Visionssystem unterstützen?

In modernen Visionssystemen ist die Bestimmung, wie viele Kameras ein einzelner Host (z. B. ein Computer oder Server) unterstützen kann, eine entscheidende Frage für die Systemgestaltung, Skalierbarkeit und Kostenoptimierung. Die Antwort hängt von mehreren miteinander verbundenen Faktoren ab, einschließlich Hardwarefähigkeiten, Softwareeffizienz, Spezifikationen von Industrie-Kameras und Anforderungen der Anwendung. Dieser Artikel untersucht diese wichtigen Variablen und bietet einen Rahmen zur Schätzung der Kamerakapazität in einem Visionssystem.

1. Hardware-Komponenten und deren Auswirkungen

Die Hardware des Hosts bildet die Grundlage für die Unterstützung von Kameras, wobei zwei wesentliche Aspekte eine Hauptrolle spielen.

1.1 Verarbeitungseinheiten: CPU und GPU

Die CPU übernimmt eine Vielzahl von Bildverarbeitungsaufgaben, von grundlegenden Filterungen bis hin zu komplexen Inferenzschritten des maschinellen Lernens. Hochaufgelöste oder hochfrequentige Kameras erzeugen große Datenvolumina, die die CPU belasten. Mehrkern-CPUs, wie der Intel i9 oder AMD Threadripper, können Aufgaben auf verschiedene Kerne verteilen, um parallele Verarbeitung durchzuführen. Andererseits revolutionieren GPUs Sehsysteme, indem sie parallele Berechnungen beschleunigen, was insbesondere für Aufgaben wie 3D-Sehen und Deep Learning im autonomen Fahren entscheidend ist. Mit GPUs optimierte Pipelines integrierter Kameras, wie CUDA in NVIDIA-GPUs, entlasten die CPU und können potenziell die Anzahl der unterstützten Kameras verdreifachen.

1.2 Speicher, Speicherplatz und Eingabe/Ausgabe

Ausreichendes RAM ist essenziell, um Videostreams und verarbeitete Daten zu pufferen. Eine 4K-Kamera bei 30 FPS erzeugt ungefähr 300 MB/s an unkomprimierten Daten, was die Speicheranforderungen in Mehrkamerasystemen steigert. Für Hochauflösungskameras sollte mindestens 4–8 GB RAM pro Kamera bereitgestellt werden. Hochgeschwindigkeits-Speicher wie NVMe SSDs und robuste I/O-Schnittstellen wie USB 3.2 und PCIe sind wichtig für die Datenaufnahme und -speicherung. Legacy-Schnittstellen können die Skalierbarkeit des Systems erheblich einschränken.

2. Industrie Kameraspezifikationen

Industriekameraparameter beeinflussen direkt die Belastung des Host-Systems, hauptsächlich durch die folgenden zwei kritischen Faktoren.

2.1 Auflösung und Bildrate

Eine höhere Auflösung und Bildrate bedeuten mehr Daten, die verarbeitet werden müssen. Eine 4K-Kamera erzeugt viermal so viele Pixel wie eine 1080p-Kamera, was die Verarbeitungsanforderungen erheblich erhöht. Ebenso generiert eine Kamera mit 120 FPS viermal so viele Daten wie eine mit 30 FPS. Im Sportfernsehen werden hochaufgelöste Kameras mit hoher Bildrate eingesetzt, was jedoch eine extrem hohe Belastung für das System darstellt und leistungsstarke Hardware erfordert, um Qualitätsverluste zu vermeiden.

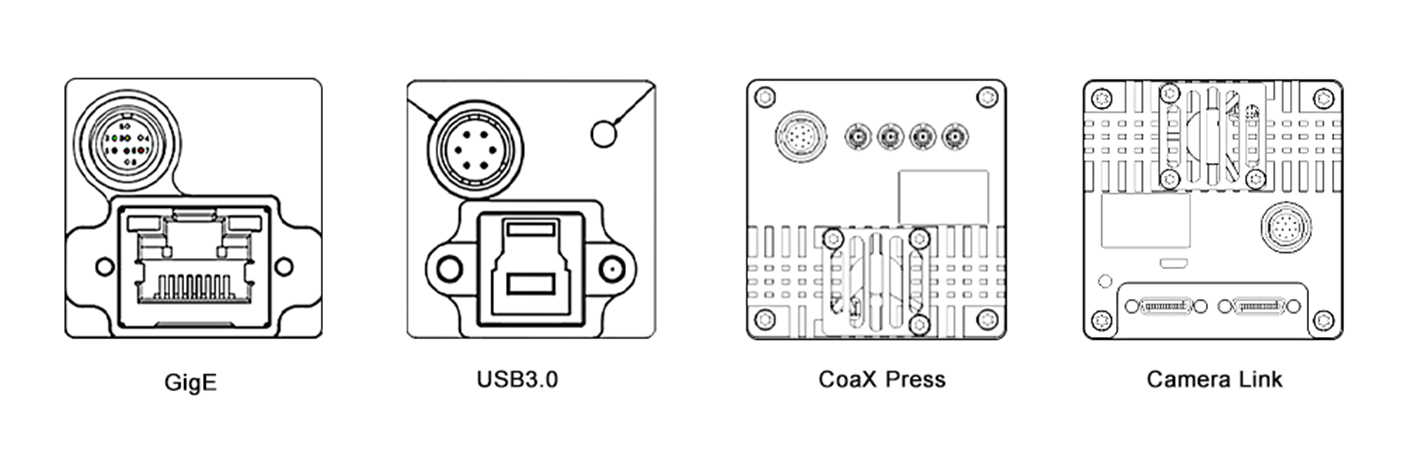

2.2 Kompression und Schnittstelle

Die Wahl des Kompressionsformats beeinflusst die Datengröße und den Verarbeitungsaufwand. Komprimierte Formate wie H.264 reduzieren die Bandbreite, erfordern aber auf dem Host ein Decodieren. Unkomprimierte Formate bieten eine höhere Genauigkeit, verbrauchen jedoch mehr Ressourcen. Zudem ist der Kameratyp der Schnittstelle entscheidend. Hochgeschwindigkeits-Schnittstellen wie GigE Vision und CoaXPress ermöglichen einen effizienten Datentransfer bei Mehrkamerasetups, während ältere Schnittstellen wie USB 2.0 die Skalierbarkeit wegen begrenzter Bandbreite einschränken.

3. Software und Verarbeitungspipeline

Die Effizienz der Software ist gleichwertig kritisch, wobei diese beiden Bereiche entscheidend für die Systemleistung sind.

3.1 Betriebssystem und Software-Tools

Das Betriebssystem und dessen Treiber bilden die Software-Grundlage. Echtzeit-Betriebssysteme (RTOS) minimieren Latenzen und sind ideal für Anwendungen wie Robotersteuerung. Linux-basierte Systeme sind aufgrund der Open-Source-Unterstützung beliebt. Optimierte Treiber verbessern die Hardwareleistung. Vision-Software und -Bibliotheken wie OpenCV, MATLAB und Deep-Learning-Frameworks wie TensorFlow und PyTorch unterscheiden sich in ihrer Recheneffizienz. Zum Beispiel kann ein Host, der ein GPU-beschleunigtes YOLO-Modell ausführt, weniger Kameras unterstützen als einer, der eine einfache Kantenerkennung verwendet, aufgrund höherer Komplexität.

3.2 Multithreading und Optimierung

Effiziente Multithreading und Parallelisierung sind entscheidend für die Maximierung der Systemleistung. Multithreading ermöglicht es Aufgaben, gleichzeitig auf CPU-Kernen zu laufen, während Parallelisierung GPUs für die Datenverarbeitung nutzt. Technologien wie OpenMP und CUDA bieten Rahmenwerke für die Implementierung. In einem Mehrkamerasicherheitssystem kann OpenMP die Verarbeitung der Kamerasignale auf CPU-Kerne verteilen und CUDA kann die Bildanalyse auf der GPU beschleunigen, was das Handling von mehr Kameras ermöglicht.

4. Anwendungsanforderungen

Die Komplexität der Vision-Aufgabe bestimmt die Ressourcenallokation, wobei Echtzeitfähigkeit und Verarbeitungskomplexität die Hauptbestimmungsfaktoren sind.

4.1 Echtzeit- vs. Offline-Verarbeitung

Echtzeitanwendungen, wie autonome Fahrzeuge und industrielle Automatisierung, erfordern sofortige Verarbeitung mit geringer Latenz, was die Anzahl der von einem Host unterstützten Kameras begrenzt. Offline-Verarbeitung, wie Batch-Videobearbeitung, kann mehr Kameras verarbeiten, liefert aber verzögerte Ergebnisse.

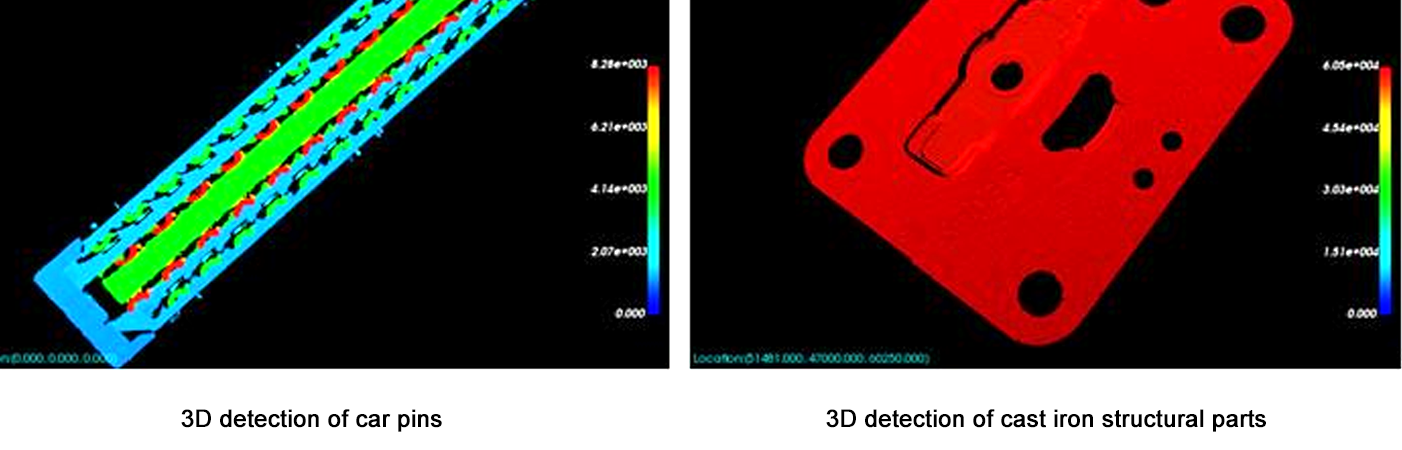

4.2 Verarbeitungskomplexität

Einfache Aufgaben wie Bewegungserkennung erzeugen einen geringen Rechenaufwand, was es einem Host ermöglicht, mehr Kameras zu unterstützen. Komplexe Aufgaben wie 3D-Rekonstruktion oder fortschrittliche Gesichtserkennung erfordern erhebliche Ressourcen und verringern die Anzahl der unterstützten Kameras. Zum Beispiel kann ein Host 10 Kameras für Bewegungserkennung unterstützen, aber nur 3 für Echtzeit-3D-Tiefenschätzung.

5. Schätzrahmen

Verwenden Sie die folgenden Schritte, um die Kamerakapazität zu schätzen:

Definieren Sie Kameraparameter: Auflösung, Framerate, Kompression und Schnittstelle.

Berechnen Sie den Datendurchsatz: Nicht komprimierte Datenrate = Auflösung × Framerate × Bit Tiefe / 8 (z. B. 1080p bei 30 FPS = 1920×1080×30×24 / 8 = ~1,4 GB/s).

Bewerten Sie die Hardwaregrenzen: Stellen Sie sicher, dass die CPU/GPU-Verarbeitungsleistung ≥ gesamter Datendurchsatz × Verarbeitungsüberschussfaktor (2–5× für komplexe Aufgaben) ist.

Test mit Prototypen: Verwenden Sie Benchmark-Tools (z.B. Intel VTune, NVIDIA Nsight), um die Ressourcennutzung für eine einzelne Kamera zu messen und dann linear zu skalieren (mit Anpassungen für Gewinne/Verluste bei der Parallelisierung).

Fazit

Die Anzahl der Kameras, die ein Host in einem Visionssystem unterstützen kann, ist keine feste Zahl, sondern ein Gleichgewicht zwischen Hardwarefähigkeiten, Kameraspezifikationen, Softwareoptimierung und Aufgabenkomplexität. Für die meisten Systeme ist es der zuverlässigste Ansatz, mit einem Prototypen zu beginnen und schrittweise aufzubauen, während die Ressourcennutzung überwacht wird. Da Hardware (z.B. schnellere GPUs, AI-Beschleuniger) und Software (z.B. Edge-Computing-Frameworks) weiterhin rasant weiterentwickelt werden, wird die Kapazität zur Unterstützung von mehr Kameras mit höherer Leistung weiter wachsen. Diese Entwicklung ermöglicht die Erstellung komplexerer und skaliierbarerer Visionslösungen und eröffnet neue Möglichkeiten in verschiedenen Branchen, von Gesundheit und Verkehr bis hin zu Sicherheit und Unterhaltung.

Dieser Artikel bietet ein grundlegendes Verständnis für Systemarchitekten und Ingenieure und betont die Notwendigkeit von maßgeschneiderten Tests und Optimierungen, um spezifische Anwendungsanforderungen zu erfüllen. Durch sorgfältige Berücksichtigung aller involvierten Faktoren ist es möglich, Visionssysteme zu entwerfen, die sowohl effizient sind als auch in der Lage, den stetig wachsenden Anforderungen moderner Anwendungen gerecht zu werden.