ビジョンシステムにおいて、一台のホストはいくつの産業用カメラをサポートできますか?

現代のビジョンシステムでは、単一のホスト(例えば、コンピュータやサーバー)が何台のカメラをサポートできるかを決定することは、システム設計、スケーラビリティ、およびコスト最適化における重要な質問です。答えは、ハードウェアの能力、ソフトウェアの効率、産業用カメラの仕様、およびアプリケーション要件など、複数の相互に関連する要因に依存します。本記事では、これらの主要な変数について探り、ビジョンシステムにおけるカメラ容量の推定フレームワークを提供します。

1. ハードウェア部品とその影響

ホストのハードウェアはカメラサポートの基盤であり、2つの主要な側面が大きな役割を果たします。

1.1 処理ユニット:CPUとGPU

CPUは、基本的なフィルタリングから複雑な機械学習の推論まで、幅広い画像処理タスクを担当します。高解像度や高フレームレートのカメラは大量のデータを生成し、CPUに負担をかけます。Intel i9やAMD ThreadripperのようなマルチコアCPUは、タスクをコア間で分散して並列処理を行うことができます。一方で、GPUは並列計算を加速することでビジョンシステムを革新し、自動運転における3Dビジョンやディープラーニングなどのタスクにおいて特に重要です。NVIDIA GPUのCUDAなど、GPU最適化パイプラインと統合されたカメラは、処理をCPUからオフロードし、サポート可能なカメラの数を最大で3倍に増やす可能性があります。

1.2 メモリ、ストレージ、およびI/O

十分なRAMは、ビデオストリームや処理済みデータをバッファするために重要です。4Kカメラで30 FPSの場合、圧縮されていないデータが約300 MB/s生成され、マルチカメラ構成ではメモリの要求が増大します。高解像度カメラでは、カメラごとに少なくとも4~8 GBのRAMを確保する必要があります。高速ストレージ、例えばNVMe SSD、そしてUSB 3.2やPCIeのような堅牢なI/Oインターフェースは、データの取り込みと保存に不可欠です。古いインターフェースはシステムのスケーラビリティを大幅に制限する可能性があります。

2. 工業用 カメラ仕様

産業用カメラのパラメータは、主に以下の2つの重要な要因を通じてホストシステムへの負荷に直接影響を与えます。

2.1 解像度とフレームレート

解像度とフレームレートが高くなることは、処理すべきデータ量が増えることを意味します。4Kカメラは1080pカメラの4倍のピクセル数を持ち、処理負荷を大幅に増加させます。同様に、120 FPSのカメラは30 FPSのカメラよりも4倍のデータを生成します。スポーツ中継では高解像度・高フレームレートのカメラが使用されますが、ホストに非常に高い負荷がかかり、品質低下を避けるためには強力なハードウェアが必要です。

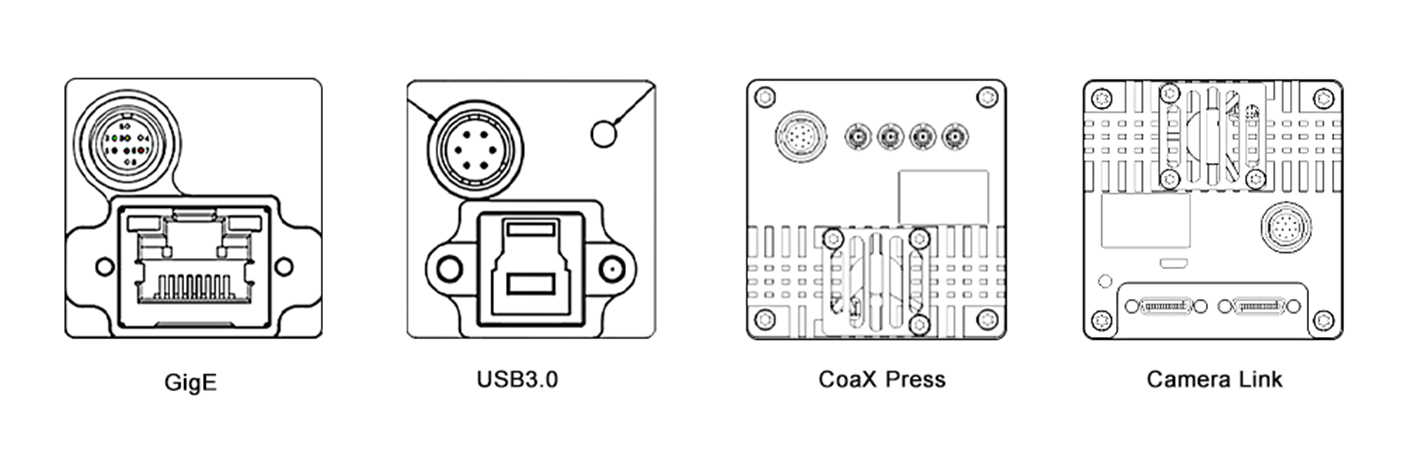

2.2 圧縮とインターフェース

圧縮形式の選択はデータサイズと処理オーバーヘッドに影響を与えます。H.264などの圧縮形式は帯域幅を削減しますが、ホストでのデコードが必要です。非圧縮形式はより高い忠実度を提供しますが、リソース消費が大きくなります。さらに、カメラインターフェースの種類も重要です。GigE VisionやCoaXPressなどの高速インターフェースはマルチカメラセットアップでの効率的なデータ転送を可能にしますが、USB 2.0のような旧式のインターフェースは帯域幅の制限によりスケーラビリティが制限されます。

3. ソフトウェアと処理パイプライン

ソフトウェアの効率も同様に重要であり、この2つの領域はシステム性能にとって鍵となります。

3.1 オペレーティングシステムとソフトウェアツール

オペレーティングシステムとそのドライバはソフトウェアの基盤を形成します。リアルタイムオペレーティングシステム(RTOS)はレイテンシーを最小限に抑え、ロボット制御などのアプリケーションに理想的です。Linuxベースのシステムはオープンソースサポートにより人気があります。最適化されたドライバはハードウェアのパフォーマンスを向上させます。OpenCV、MATLAB、TensorFlowやPyTorchのようなディープラーニングフレームワークなどのビジョンソフトウェアやライブラリは、計算効率が異なります。例えば、GPU加速型のYOLOモデルを実行するホストは、より高い複雑さのため、基本的なエッジ検出を使用するものよりも少ないカメラ数しかサポートできない場合があります。

3.2 マルチスレッディングと最適化

効率的なマルチスレッディングと並列化は、システムパフォーマンスを最大化するための鍵です。マルチスレッディングはタスクをCPUコア上で同時実行させ、並列化はデータ処理にGPUを活用します。OpenMPやCUDAなどの技術は、それらの実装フレームワークを提供します。複数カメラ監視システムでは、OpenMPがカメラフィードの処理をCPUコアに分散し、CUDAが画像分析をGPU上で高速化することで、より多くのカメラに対応可能になります。

4. アプリケーション要件

ビジョンタスクの複雑さがリソース割り当てを決定し、リアルタイム性と処理の複雑さが主な決定要素となります。

4.1 リアルタイム処理とオフライン処理

自動運転や産業自動化のようなリアルタイムアプリケーションでは、低遅延での処理が求められるため、ホストがサポートできるカメラの数に制限が生じます。バッチビデオ分析のようなオフライン処理は、より多くのカメラに対応できますが、結果が出るまで時間がかかります。

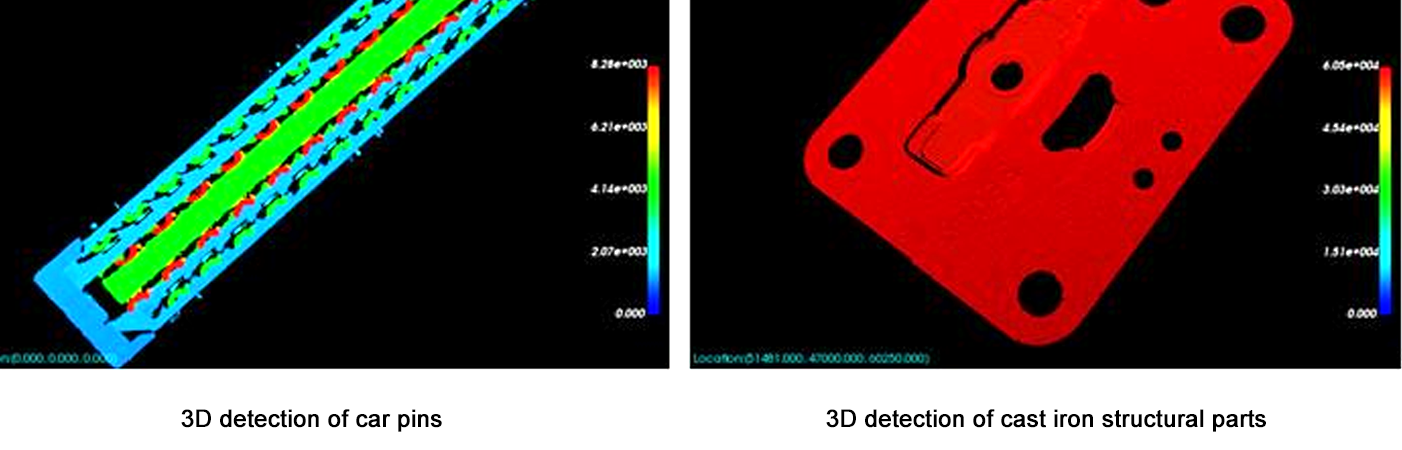

4.2 処理の複雑さ

動き検出のような単純なタスクは低い計算負荷しか必要としないため、ホストがより多くのカメラをサポートできます。一方、3D再構築や高度な顔認識のような複雑なタスクは多大なリソースを必要とし、サポートできるカメラの数を減らします。例えば、動き検出では10台のカメラをサポートできるホストでも、リアルタイムの3D深度推定では3台しかサポートできない場合があります。

5. 推定フレームワーク

カメラ容量を推定するには次のステップを使用してください:

カメラパラメータを定義する: 解像度、フレームレート、圧縮、インターフェース。

データスループットを計算する: 非圧縮データレート = 解像度 × フレームレート × ビット深度 / 8 (例:1080pで30 FPSの場合 = 1920×1080×30×24 / 8 = 約1.4 GB/s)。

ハードウェアの限界を評価する: CPU/GPUの処理能力 ≥ 総データスループット × 処理オーバーヘッド係数(複雑なタスクでは2–5倍)であることを確認します。

プロトタイプでのテスト: ベンチマークツール(例: Intel VTune, NVIDIA Nsight)を使用して、単一のカメラのリソース使用量を測定し、並列化による増分/減分の調整を加えながら線形にスケーリングします。

まとめ

ビジョンシステムにおけるホストがサポートできるカメラの数は固定されたものではなく、ハードウェア能力、カメラ仕様、ソフトウェア最適化、およびタスクの複雑さのバランスによって異なります。ほとんどのシステムでは、プロトタイプから始め、リソース使用状況を監視しながら段階的に拡張する方法が最も信頼性の高いアプローチです。ハードウェア(例: 高速なGPUやAIアクセラレータ)やソフトウェア(例: エッジコンピューティングフレームワーク)が急速に進化しているため、より高性能で多くのカメラをサポートする容量も引き続き拡大しています。この進化により、より洗練されスケーラブルなビジョンソリューションの開発が可能となり、医療や輸送、セキュリティ、エンターテインメントなどさまざまな業界で新しい可能性が広がります。

この記事は、システムアーキテクトやエンジニア向けの基礎的な理解を提供し、特定のアプリケーション要件を満たすためにカスタマイズされたテストと最適化の必要性を強調しています。すべての関連要素を慎重に考慮することで、効率的でありながら、現代のアプリケーションの増大する要求に対応できるビジョンシステムを設計することが可能です。