비전 시스템에서 하나의 호스트가 지원할 수 있는 산업용 카메라는 몇 대입니까?

현대 시각 시스템에서 단일 호스트(예: 컴퓨터 또는 서버)가 지원할 수 있는 카메라의 수를 결정하는 것은 시스템 설계, 확장성 및 비용 최적화에 있어 중요한 질문입니다. 이 답변은 하드웨어 능력, 소프트웨어 효율성, 산업용 카메라 사양 및 응용 요구 사항을 포함한 여러 상호 연관된 요인에 따라 달라집니다. 본 문서에서는 이러한 주요 변수들을 탐구하고 비전 시스템에서 카메라 용량을 추정하기 위한 프레임워크를 제공합니다.

1. 하드웨어 구성요소 및 그 영향

호스트의 하드웨어는 카메라 지원의 기반이며, 두 가지 주요 측면이 큰 역할을 합니다.

1.1 처리 장치: CPU와 GPU

CPU는 기본 필터링에서 복잡한 머신 러닝 추론에 이르기까지 다양한 이미지 처리 작업을 담당합니다. 고해상도 또는 고프레임레이트 카메라는 CPU를 과부하시키는 큰 데이터량을 생성합니다. 인텔 i9나 AMD 스레드ripper와 같은 멀티코어 CPU는 작업을 코어들 사이에 분산시켜 병렬 처리를 수행할 수 있습니다. 반면에 GPU는 자율 주행에서의 3D 비전과 딥 러닝과 같은 작업에 특히 중요한 병렬 컴퓨팅을 가속화하여 비전 시스템을 혁신합니다. NVIDIA GPU의 CUDA와 같은 GPU 최적화 파이프라인과 통합된 카메라는 처리를 CPU에서 분담하여 지원 가능한 카메라 수를 잠재적으로 세 배로 늘릴 수 있습니다.

1.2 메모리, 저장소 및 I/O

충분한 RAM은 비디오 스트림과 처리된 데이터를 버퍼링하는 데 필수적입니다. 30 FPS의 4K 카메라는 약 300 MB/s의 압축되지 않은 데이터를 생성하여 다중 카메라 구성을 사용할 때 메모리 요구 사항이 증가합니다. 고해상도 카메라의 경우 카메라당 최소 4–8 GB의 RAM을 할당해야 합니다. NVMe SSD와 같은 고속 저장 장치 및 USB 3.2와 PCIe와 같은 강력한 I/O 인터페이스는 데이터 입력 및 저장에 중요합니다. 구형 인터페이스는 시스템의 확장성에 심각한 제한을 가할 수 있습니다.

2. 산업 카메라 사양

산업용 카메라 파라미터는 주 시스템의 부하에 직접적인 영향을 미치며, 주로 다음 두 가지 중요한 요인을 통해 작동합니다.

2.1 해상도 및 프레임 속도

더 높은 해상도와 프레임 속도는 처리해야 할 더 많은 데이터를 의미합니다. 4K 카메라는 1080p 카메라보다 네 배 더 많은 픽셀을 생성하여 처리 요구 사항을 크게 증가시킵니다. 마찬가지로, 120 FPS 카메라는 30 FPS 카메라보다 네 배 더 많은 데이터를 생성합니다. 스포츠 중계에서는 고해상도, 고프레임률 카메라가 사용되지만 이는 매우 높은 부하를 주기 때문에 품질 손실 없이 실행하려면 강력한 하드웨어가 필요합니다.

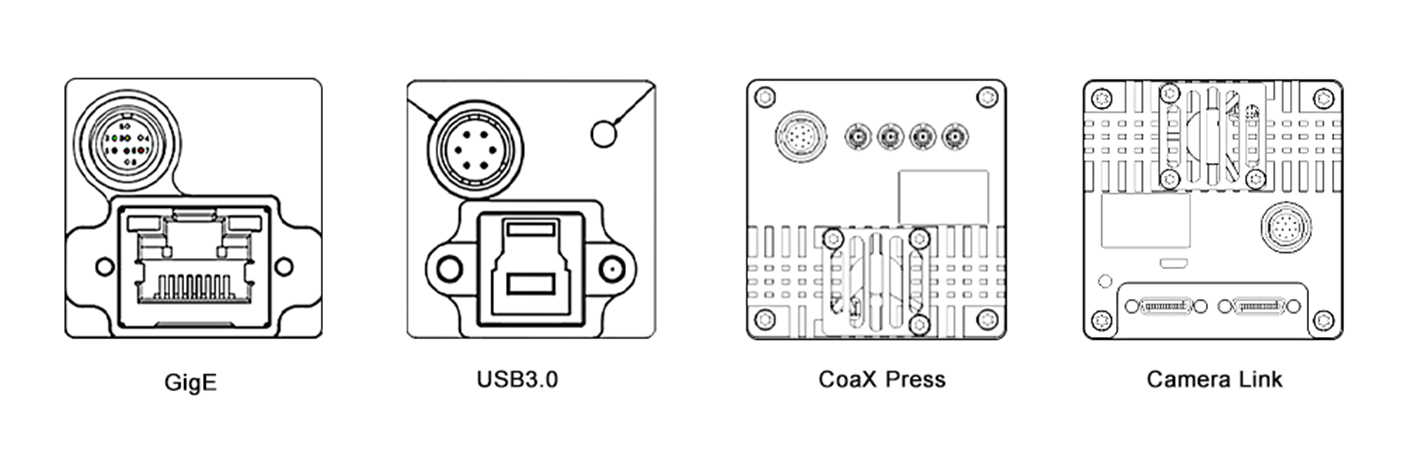

2.2 압축 및 인터페이스

압축 형식의 선택은 데이터 크기와 처리 오버헤드에 영향을 미칩니다. H.264와 같은 압축된 형식은 대역폭을 줄이지만 호스트에서 디코딩이 필요합니다. 비압축 형식은 더 높은 충실도를 제공하지만 더 많은 리소스를 소비합니다. 또한 카메라 인터페이스 유형은 매우 중요합니다. GigE Vision과 CoaXPress와 같은 고속 인터페이스는 다중 카메라 설정에서 효율적인 데이터 전송을 가능하게 하지만 USB 2.0과 같은 구형 인터페이스는 제한된 대역폭으로 인해 확장성이 제한됩니다.

3. 소프트웨어 및 처리 파이프라인

소프트웨어 효율성도 equally 중요하며, 이 두 영역은 시스템 성능의 핵심입니다.

3.1 운영 체제 및 소프트웨어 도구

운영 체제와 드라이버는 소프트웨어의 기반이 됩니다. 실시간 운영 체제(RTOS)는 로봇 제어와 같은 응용 프로그램에 이상적인 저 지연을 제공합니다. Linux 기반 시스템은 오픈소스 지원 덕분에 인기가 있습니다. 최적화된 드라이버는 하드웨어 성능을 향상시킵니다. OpenCV, MATLAB과 같은 비전 소프트웨어 및 라이브러리, TensorFlow와 PyTorch와 같은 딥러닝 프레임워크는 계산 효율성이 다릅니다. 예를 들어, GPU 가속 YOLO 모델을 실행하는 호스트는 기본 엣지 감지 알고리즘을 사용하는 것보다 복잡도가 높아 카메라 수를 적게 지원할 수 있습니다.

3.2 멀티스레딩 및 최적화

효율적인 멀티스레딩과 병렬화는 시스템 성능을 최대화하는 데 핵심입니다. 멀티스레딩은 작업들을 CPU 코어에서 동시에 실행하도록 허용하며, 병렬화는 데이터 처리를 위해 GPU를 활용합니다. OpenMP와 CUDA 같은 기술들은 이를 구현하기 위한 프레임워크를 제공합니다. 다중 카메라 감시 시스템에서는 OpenMP가 카메라 피드 처리를 CPU 코어에 분산시키고, CUDA는 GPU에서 이미지 분석을 가속화하여 더 많은 카메라를 처리할 수 있도록 합니다.

4. 응용 요구사항

비전 작업의 복잡성은 리소스 할당을 결정짓는 요소이며, 실시간성과 처리 복잡성이 주요 판단 기준입니다.

4.1 실시간 대 오프라인 처리

자율 주행 및 산업 자동화와 같은 실시간 애플리케이션은 낮은 지연 시간을 요구하여 호스트가 지원할 수 있는 카메라 수에 제한을 줍니다. 배치 비디오 분석과 같은 오프라인 처리는 더 많은 카메라를 처리할 수 있지만 결과가 지연됩니다.

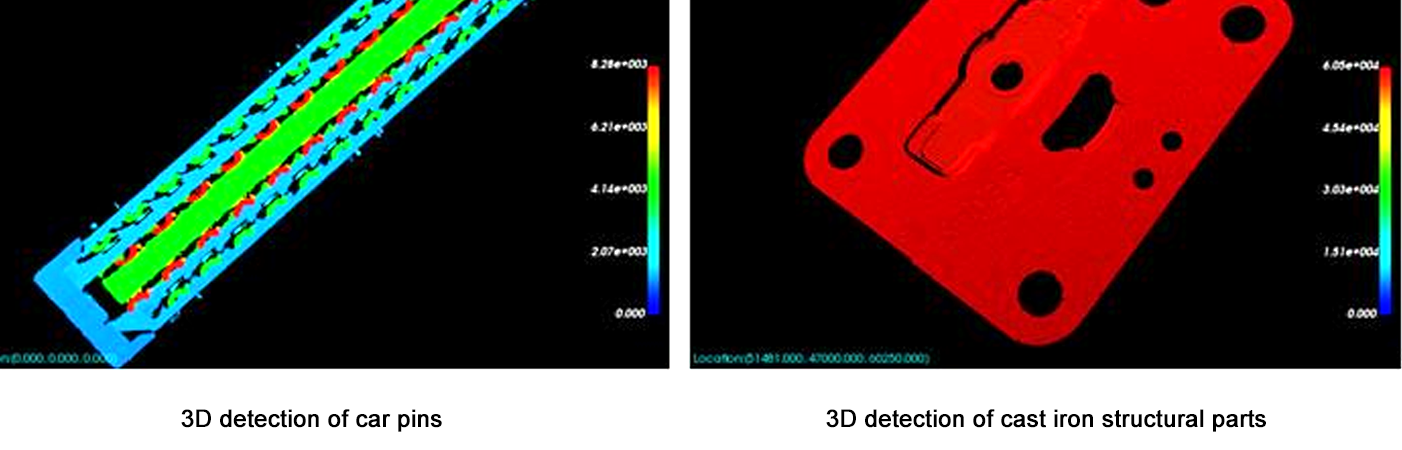

4.2 처리 복잡성

운동 감지와 같은 간단한 작업은 낮은 계산 부하를 발생시켜 호스트가 더 많은 카메라를 지원할 수 있도록 하지만, 3D 재구성이나 고급 얼굴 인식과 같은 복잡한 작업은 많은 리소스를 필요로 하여 지원 가능한 카메라 수가 줄어듭니다. 예를 들어, 운동 감지에는 10개의 카메라를 지원할 수 있지만 실시간 3D 깊이 추정에는 단지 3개의 카메라만을 지원할 수 있습니다.

5. 추정 프레임워크

카메라 용량을 추정하기 위해 다음 단계를 사용하십시오:

카메라 매개변수 정의: 해상도, 프레임 속도, 압축 및 인터페이스.

데이터 스루풋 계산: 압축되지 않은 데이터 속도 = 해상도 × 프레임 속도 × 비트 깊이 / 8 (예: 1080p, 30 FPS = 1920×1080×30×24 / 8 = 약 1.4 GB/s).

하드웨어 한계 평가: CPU/GPU 처리 능력 ≥ 총 데이터 스루풋 × 처리 오버헤드 요인 (복잡한 작업에 대해 2–5×).

프로토타입으로 테스트하기: 기준 도구(Intel VTune, NVIDIA Nsight 등)를 사용하여 단일 카메라의 리소스 사용량을 측정한 후, 병렬화로 인한 이득/손실을 조정하면서 선형적으로 확장합니다.

결론

비전 시스템에서 호스트가 지원할 수 있는 카메라의 수는 고정된 숫자가 아니라 하드웨어 능력, 카메라 사양, 소프트웨어 최적화, 그리고 작업 복잡성 사이의 균형입니다. 대부분의 시스템에서는 프로토타입으로 시작하여 리소스 사용량을 모니터링하면서 점진적으로 확장하는 것이 가장 신뢰할 수 있는 접근 방식입니다. 하드웨어(예: 더 빠른 GPU, AI 가속기)와 소프트웨어(예: 엣지 컴퓨팅 프레임워크)가 급격히 발전함에 따라 더 많은 카메라를 더 높은 성능으로 지원할 수 있는 용량도 계속 증가할 것입니다. 이러한 발전은 보다 정교하고 확장 가능한 비전 솔루션의 개발을 가능하게 하여 의료, 교통, 보안, 엔터테인먼트 등 다양한 산업에서 새로운 가능성을 열어줄 것입니다.

이 문서는 시스템 아키텍트와 엔지니어들을 대상으로 하여, 특정 애플리케이션 요구사항을 충족하기 위해 맞춤형 테스트와 최적화의 필요성을 강조하며 기초적인 이해를 제공합니다. 모든 관련 요소를 신중하게 고려하면, 현대 애플리케이션의 점점 증가하는 요구사항을 처리할 수 있을 뿐만 아니라 효율적인 비전 시스템을 설계하는 것이 가능합니다.