Hoeveel industriële camera's kan één host ondersteunen in een visiesysteem?

In moderne visiesystemen is het bepalen hoeveel camera's een enkele host (bijvoorbeeld een computer of server) kan ondersteunen een cruciale vraag voor systeemontwerp, schaalbaarheid en kostenoptimalisatie. Het antwoord hangt af van meerdere onderling verbonden factoren, zoals hardwarecapaciteit, softwareefficiëntie, specificaties van industriële camera's en toepassingsvereisten. Dit artikel verkent deze belangrijke variabelen en biedt een kader voor het schatten van de cameracapaciteit in een visiesysteem.

1. Hardware-onderdelen en hun invloed

De hardware van de host vormt de basis voor camera-ondersteuning, met twee belangrijke aspecten die een grote rol spelen.

1.1 Verwerkingseenheden: CPU en GPU

De CPU behandelt een breed scala aan afbeeldingsverwerkingsopdrachten, van basisfiltering tot complexe machine learning inferentie. Hoge resolutie of hoge framesnelheid camera's genereren grote gegevensvolumes, wat de CPU belast. Multi-core CPUs, zoals de Intel i9 of AMD Threadripper, kunnen taken over meerdere kernen verdelen voor parallelle verwerking. Aan de andere kant revolutioneren GPUs visiesystemen door parallelle berekeningen te versnellen, vooral cruciaal voor taken zoals 3D-visie en diep leerproces in autonoom rijden. Camera's geïntegreerd met GPU-geoptimaliseerde pipelines, zoals CUDA in NVIDIA GPUs, nemen verwerking over van de CPU, waardoor het aantal ondersteunde camera's mogelijk kan verdrievoudigen.

1.2 Geheugen, Opslag en I/O

Voldoende RAM is essentieel om videostreams en verwerkte data te bufferen. Een 4K-camera op 30 FPS genereert ongeveer 300 MB/s aan ongecomprimeerde data, wat de geheugenvereisten verhoogt in multi-camera-opstellingen. Voor hoge resolutie camera's moet er minimaal 4-8 GB RAM per camera worden toegewezen. Hoge-snelheidopslag zoals NVMe SSD's en robuuste I/O-interfaces zoals USB 3.2 en PCIe zijn cruciaal voor het opnemen en opslaan van data. Oudere interfaces kunnen de schaalbaarheid van het systeem ernstig beperken.

2. Industrieel Camera Specificaties

Industriële camera-parameters beïnvloeden rechtstreeks de belasting op het hostsysteem, voornamelijk door de volgende twee kritieke factoren.

2.1 Resolutie en Framesnelheid

Een hogere resolutie en frame rate betekenen meer data om te verwerken. Een 4K-camera produceert vier keer zoveel pixels dan een 1080p-camera, wat de verwerkingsvereisten aanzienlijk verhoogt. Evenzo genereert een camera van 120 FPS vier keer zoveel data dan een camera van 30 FPS. In sportuitzendingen worden cameras met hoge resolutie en hoge frame rate gebruikt, maar leggen een extreem hoge belasting op het systeem, waarvoor krachtige hardware nodig is om kwaliteitsverlies te voorkomen.

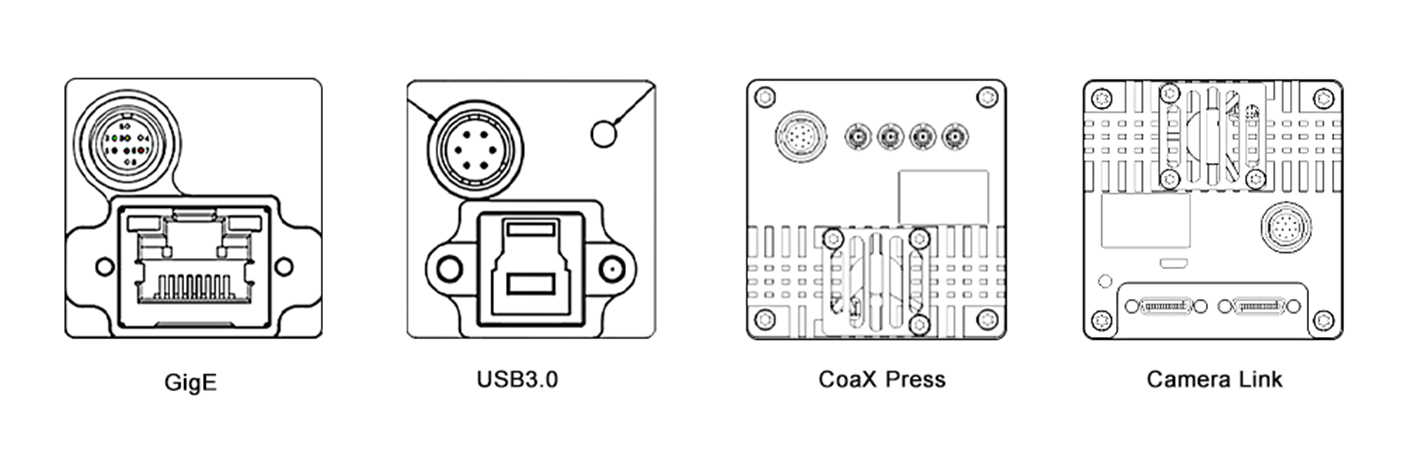

2.2 Compressie en Interface

De keuze van het compressieformaat heeft invloed op de gegevensgrootte en de verwerkingsoverhead. Gecomprimeerde formaten zoals H.264 verminderen de bandbreedte, maar vereisen decodering op het systeem. Ongecomprimeerde formaten bieden een hogere kwaliteit, maar consumeren meer resources. Bovendien is het type camera-interface cruciaal. Hoogsnelheidsinterfaces zoals GigE Vision en CoaXPress maken efficiënte gegevenstransfer mogelijk voor meercamera-opstellingen, terwijl ouderewereldinterfaces zoals USB 2.0 de schaalbaarheid beperken door de beperkte bandbreedte.

3. Software en Verwerkingspijplijn

Software-efficiëntie is even kritisch, met deze twee gebieden als sleutel voor systeemprestaties.

3.1 Besturingssysteem en Software Tools

Het besturingssysteem en zijn drivers vormen de softwarebasis. Real-time besturingssystemen (RTOS) minimaliseren vertraging, ideaal voor toepassingen zoals robotbesturing. Linux-gebaseerde systemen zijn populair vanwege open-source ondersteuning. Geoptimaliseerde drivers verbeteren de hardwareprestaties. Visiesoftware en bibliotheken, zoals OpenCV, MATLAB en deep learning frameworks zoals TensorFlow en PyTorch, verschillen in reken-efficiëntie. Bijvoorbeeld, een host die een GPU-versneld YOLO-model uitvoert, kan minder camera's ondersteunen dan een die basisranddetectie gebruikt vanwege hogere complexiteit.

3.2 Multithreading en Optimalisatie

Efficiënte multithreading en parallelisatie zijn essentieel om de systeemprestaties te maximaliseren. Multithreading laat taken gelijktijdig draaien op CPU-kernen, terwijl parallelisatie GPUs gebruikt voor gegevensverwerking. Technologieën zoals OpenMP en CUDA bieden kaders voor implementatie. In een multicamera-bewakingsysteem kan OpenMP camerafeedverwerking verdelen over CPU-kernen en kan CUDA beeldanalyse versnellen op de GPU, waardoor meer camera's kunnen worden behandeld.

4. Toepassingsvereisten

De complexiteit van de visietaak bepaalt de resource-toewijzing, met real-time en verwerkingscomplexiteit als de belangrijkste bepalende factoren.

4.1 Real-Time versus Offline Verwerking

Real-time toepassingen, zoals autonoom rijden en industriële automatisering, vereisen directe verwerking met lage latentie, wat het aantal camera's dat een host kan ondersteunen beperkt. Offline verwerking, zoals batch videobewerking, kan meer camera's afhandelen maar levert uitgestelde resultaten.

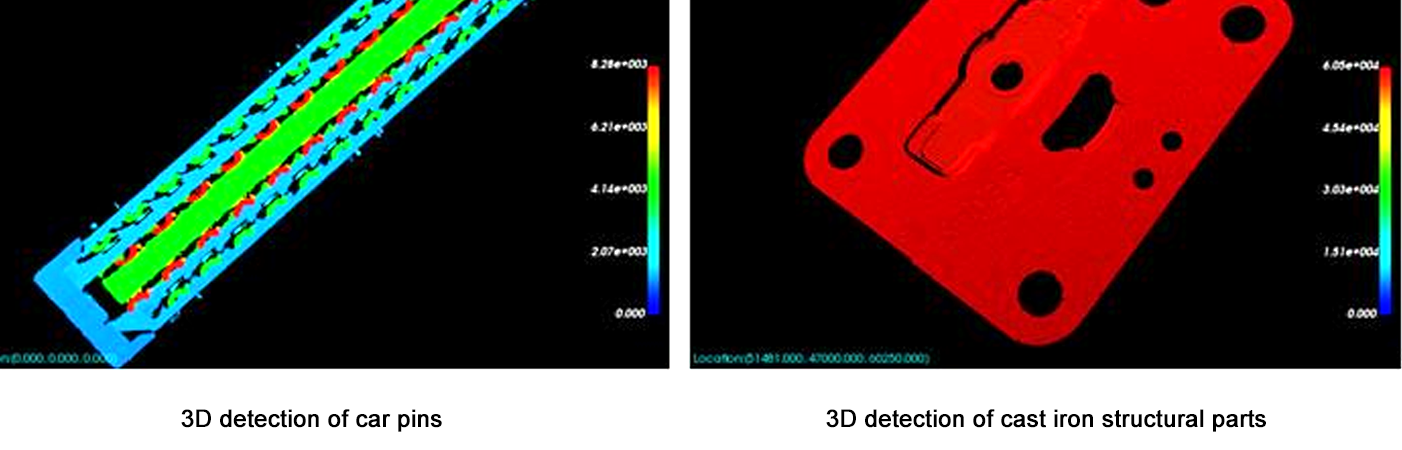

4.2 Verwerkingscomplexiteit

Eenvoudige taken zoals bewegingsdetectie leggen een lage rekenlast op, wat een host toelaat om meer camera's te ondersteunen. Complexere taken zoals 3D-reconstructie of geavanceerd gezichtsherkenning vereisen aanzienlijke resources, waardoor het aantal ondersteunde camera's afneemt. Bijvoorbeeld, een host kan bijvoorbeeld 10 camera's ondersteunen voor bewegingsdetectie, maar slechts 3 voor real-time 3D diepteschatting.

5. Schattingssysteem

Gebruik de volgende stappen om de camera-capaciteit in te schatten:

Definieer Camera Parameters: Resolutie, framesnelheid, compressie en interface.

Bereken Data Doorvoer: Ongecomprimeerde Data Rate = Resolutie × Framesnelheid × Bitdiepte / 8 (bijv., 1080p op 30 FPS = 1920×1080×30×24 / 8 = ~1,4 GB/s).

Evalueer Hardwarelimieten: Zorg ervoor dat de CPU/GPU-verwerkingskracht ≥ totale data doorvoer × verwerkingsoverhead factor (2–5× voor complexe taken).

Testen met prototypes: Gebruik benchmarktools (bijv., Intel VTune, NVIDIA Nsight) om de resourcegebruik te meten voor een enkele camera, en schaal vervolgens lineair (met aanpassingen voor winsten/verliezen door parallelisatie).

Conclusie

Het aantal camera's dat een host in een visiesysteem kan ondersteunen is geen vaste waarde, maar een evenwicht tussen hardwarecapaciteiten, camer specificaties, softwareoptimalisatie en taakcomplexiteit. Voor de meeste systemen is het betrouwbaarste aanpakken om te beginnen met een prototype en geleidelijk te schalen terwijl je het resourcegebruik in de gaten houdt. Aangezien hardware (bijv., snellere GPUs, AI-versnellers) en software (bijv., edge computing frameworks) blijven evolueren op een snel tempo, zal de capaciteit om meer camera's met hogere prestaties te ondersteunen blijven groeien. Deze evolutie maakt het mogelijk om geavanceerdere en schaalbare visieoplossingen te ontwikkelen, wat nieuwe mogelijkheden biedt in verschillende sectoren, van gezondheidszorg en vervoer tot veiligheid en entertainment.

Dit artikel biedt een basisbegrip voor systeemarchitecten en ingenieurs, waarbij de noodzaak van op maat gemaakte testen en optimalisatie om specifieke toepassingsvereisten te voldoen wordt benadrukt. Door zorgvuldig alle betrokken factoren in overweging te nemen, is het mogelijk visiesystemen te ontwerpen die zowel efficiënt zijn als in staat om de steeds toenemende eisen van moderne toepassingen aan te pakken.